Q-学习(Q-Learning)是一种无模型的强化学习算法,用于学习在给定状态下采取哪种动作以最大化某种长期收益。其核心是Q-函数,用于评估在特定状态下采取特定动作的价值。

Q-学习的基本原理和步骤包括:

- Q-函数:Q-函数Q(s, a)代表在状态s下采取动作a所期望的未来收益。这个函数通常通过Q-表来实现,表中的每个元素代表一个状态-动作对的价值。

- 探索和利用:算法在学习初期倾向于探索(尝试不同的动作以了解它们的影响),随着学习的进行,逐渐转向利用(选择已知会带来高收益的动作)。

- 学习更新规则:Q-学习通过以下规则更新Q-表:

Q(s,a)←Q(s,a)+α(r+γmaxa′Q(s′,a′)−Q(s,a))

其中,α是学习率(决定新信息覆盖旧信息的速度),r是立即奖励,γ 是折扣因子(决定未来奖励的重要性),s′ 是采取动作后的新状态, a′是新状态下可能的动作

- 收敛性:在适当的条件下,Q-学习保证了Q-表最终会收敛到最优的Q-函数,这意味着算法能够学习到在任何状态下采取最优动作的策略。

Q-学习在各种领域都有应用,尤其是在那些状态空间和动作空间较大,难以以其他方式建模的情况下。通过这种方式,算法能够通过与环境的交互学习到如何在不同情况下做出最佳决策。

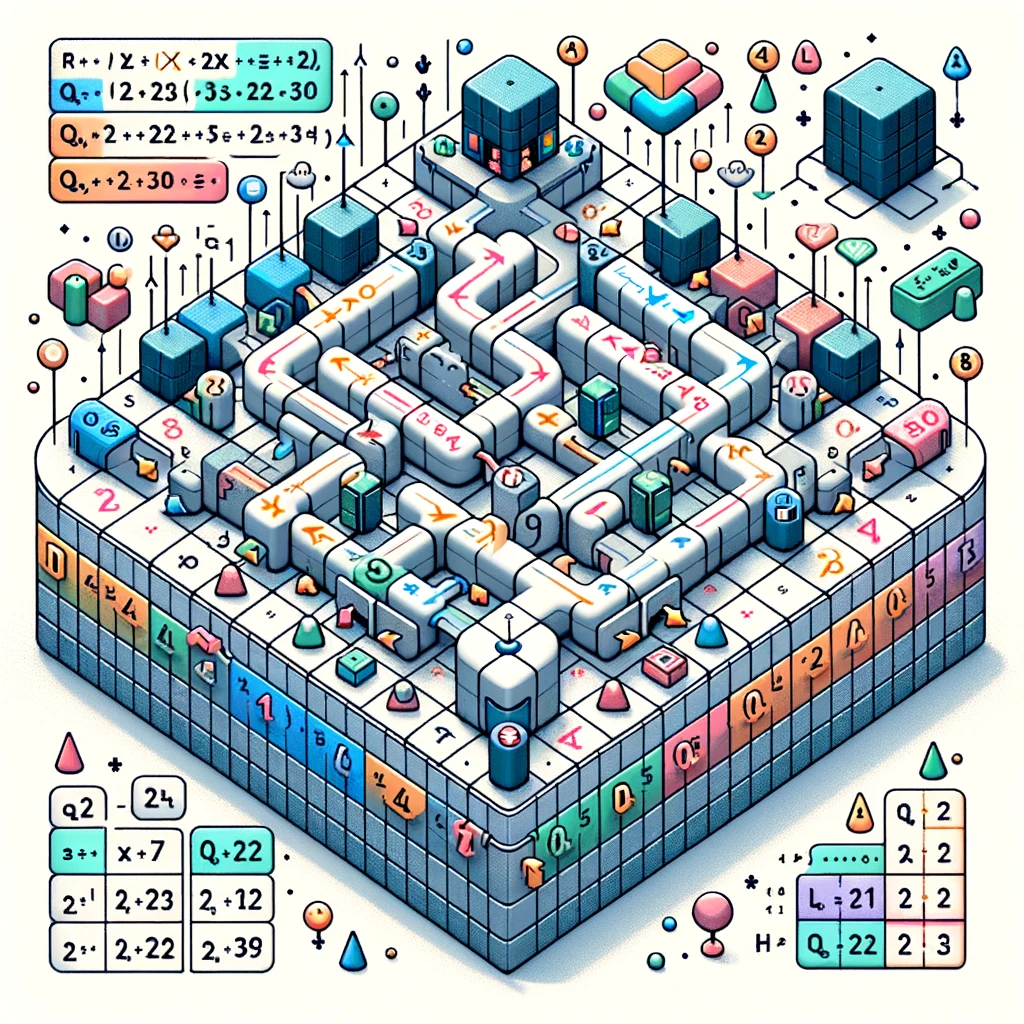

在这张图中,我尝试用一个视觉方式解释Q-学习的概念。图中展示了一个类似格子的环境,不同的方格代表不同的状态。每个方格(状态)有指向其他方格的箭头,这些箭头象征着从当前状态出发可能采取的动作。在每个箭头旁边,有数字表示Q值,这些数字显示了采取这些动作所估计的回报。

此外,图中还展示了一个Q表的部分,这是一个以状态为行、动作为列的矩阵,填充了Q值。图中还包含了一个简单的公式:“Q(s, a) = Q(s, a) + α (r + γ max Q(s', a') - Q(s, a))”,这是Q-学习更新规则的表达。

整个图示旨在清晰、生动地传达Q-学习的基本原理。